Executivul european intenționează să folosească viitoarea reglementare pentru platformele digitale (Digital Services Act) care va fi prezentată pe 15 decembrie, pentru a încerca să determine marile companii web să fie transparente în ceea ce privește funcționarea algoritmilor. Algoritmii iau milioane de decizii pe zi, dar nu sunt feriți de prejudecăți. Pe de altă parte, companiile au investit milioane de dolari în algoritmi performanți și nu vor fi dornice să dezvăluie date despre ei.

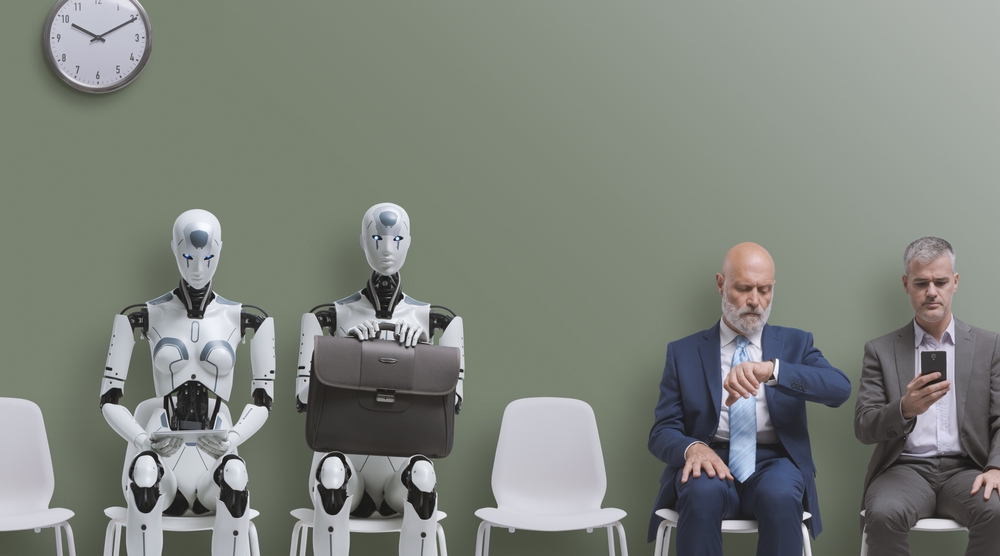

Companiile au investit enorm în algoritmi și țin mult la secretele legate de aceștia. Criticii spun însă că algoritmii nu sunt neutri, ci reflectă prejudecățile oamenilor care i-au creat, printre exemple fiind faptul că algoritmii discriminează persoanele de culoare, dar și femeile.

Algoritmii discriminează pentru că pleacă de la informații în care anumite părți ale realității sunt sub-reprezentate, un exemplu clasic fiind la sistemele de recunoaștere facială care dau rezultate mai puțin precise la persoanele de culoare, fiindcă din start, sunt încărcate mai puține fotografii cu persoane de culoare în uriașele baze de date.

Marile platforme "vor trebui să ne spună modul în care decid ce informații și produse recomandă și ce ascund și să ne ofere capacitatea de a influența acele decizii. Vor trebui să ne spună cine plătește anunțurile pe care le vedem și să aflăm de ce am fost vizați ”, declara vicepreședintele Comisiei Europene, Margrethe Vestager, la sfârșitul lunii octombrie.

Rețelele sociale spun că sunt neutre din punct de vedere politic, "dar chiar sunt cu adevărat? Nimeni nu le poate observa în detaliu comportamentul în prezent", a explicat recent Benoit Loutrel, care a condus o misiune de studiu a Facebook, în Franța.

„Când platformele spun

ONG-ul Algorithm Watch sugerează diferite soluții, variind de la examinarea datelor de instruire a modelului de inteligență artificială, până la recitirea codului, inclusiv un „test” pentru a compara datele de intrare și de ieșire.

„În cazul mașinilor foarte complexe, chiar și inginerii care le-au dezvoltat nu știu neapărat de ce iese un astfel de rezultat, așa că pentru a determina dacă un sistem perpetuează lucruri părtinitoare, este necesar să se poată efectua mai multe teste”, explică AFP Mackenzie Nelson de la ONG-ul Algorithm Watch.

Facebook susține, în răspunsurile sale la consultarea publică cu privire la proiectul de regulament, că „schimbul de detalii cu privire la funcționarea algoritmilor (...) ar putea permite actorilor cu intenții rele să ocolească mai eficient mecanismele de detectare”.

Compania avertizează, de asemenea, cu privire la riscul scurgerii de date cu caracter personal: „credem că este esențial să existe o structură de protecție pentru orice informație partajată cu autoritățile, prin definirea clară a condițiilor de partajare a datelor și a persoanelor care au acces la acestea, astfel încât să se asigure confidențialitatea”.

Surse: AFP, Bloomberg