Microsoft va refuza accesul poliției americane la tehnologia sa de recunoaștere facială, în absența legislației, la fel ca alți giganți de internet îngrijorați de posibilitatea abuzurilor și pe fundalul demonstrațiilor împotriva violenței poliției, scrie AFP.

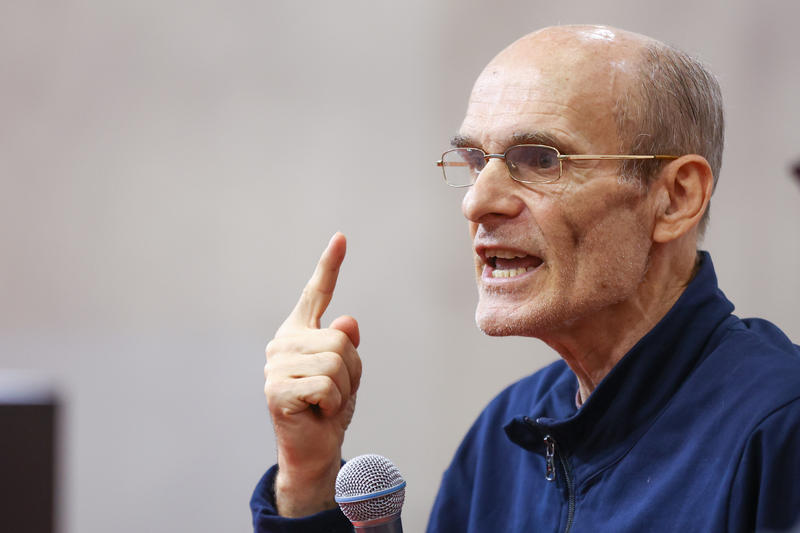

"Nu vom vinde tehnologia noastră de recunoaștere facială instituțiilor care aplică legea din SUA chiar acum și până nu există o legislație federală puternică bazată pe drepturile omului, nu vom vinde această tehnologie pentru aplicarea legii ", a declarat Brad Smith, un înalt oficial Microsoft la o masă rotundă găzduită de Washington Post.

Dincolo de utilizarea de către poliție, Microsoft intenționează să pună la punct mecanisme pentru a evalua utilizarea acestei tehnologii controversate chiar și în afara poliției, a adăugat el.

„În ultimii doi ani ne-am concentrat pe dezvoltarea și punerea în aplicare a principiilor solide care să ne ajute în utilizarea recunoașterii faciale și am solicitat în mod repetat o reglementare guvernamentală puternică”, a spus Smith.

Microsoft s-a angajat să lucreze cu alți susținători ai legislației în acest domeniu și a declarat că profită de ocazie „pentru a consolida procesele de revizuire pentru clienții noștri care doresc să utilizeze această tehnologie la scară largă ".

Amazon a decis miercuri să interzică poliției să folosească programul său de recunoaștere facială Rekognition pentru un an, pentru a da timp Congresului să „pună în aplicare reguli adecvate” pentru utilizarea tehnologiei.

Timnit Gebru, lider al echipei Google pe tema folosirii etice a inteligenței artificiale, spune pentru New York Times că tehnologia este mult prea periculoasă în prezent, astfel încât să fie lăsată pe mâna forțelor de ordine.

Gebru explică în primul rând că sunt erori mari în identificarea fețelor persoanelor de culoare, iar asta înseamnă o rată de detecție mai mică pentru cei cu pielea mai închisă și, implicit, arestarea unor oameni nevinovați.

Și când identificarea se face în mod corect, tehnologia poate fi folosită în mod abuziv, cum s-a întâmplat la un protest din Baltimore unde poliția s-a folosit de imaginile colectate pentru a-i identifica pe participanți, comparând imaginile cu pozele de pe rețelele sociale.

Apoi mai este conceptul de ”automation bias” care se referă la faptul că, deși un polițist, văzând o imagine livrată de sistem, consideră că nu seamănă cu cea a suspectului, îl va aresta pe acel suspect doar fiindcă sistemele de recunoaștere spun că în proporție de 99% este persoana căutată. De multe ori detecțiile semnalate de sistem pentru persoanele de culoare sunt mult mai inexacte decât cele realizate de oamenii care se uită la poze și compară.

Gebru spune că, luate împreună, trei lucruri sunt periculoase când este vorba de recunoașterea facială: încrederea excesivă în tehnologie, tendința de a o folosi în mod impropriu și lipsa de transparență.